Wie kann es sein, dass Webseiten wie Wikipedia immer erreichbar sind? Seit wir in Teil #1 gestartet sind, haben wir bereits einiges über das Internet erfahren. Wir wissen, dass Computer sich gegenseitig Anfragen und Antworten durch ein Kabelnetz zusenden. Einen Teil dieser Computer – die „Clients“ – kennen wir aus dem Alltag sehr gut: Es sind die Smartphones, Laptops, TV-Geräte bei uns zuhause. Sie kommunizieren mit „Servern“ die irgendwo auf der Welt im Internet stehen und für die meisten Menschen im Verborgenen arbeiten. In diesem Teil der Internetgeschichten widmen wir uns dieser unsichtbaren Seite des Internets. Wo stehen diese Computer und wer kümmert sich darum. Wie kann es sein, dass das Internet nie schläft?

Jeder Computer, der Anfragen entgegen nimmt, wird „Server“ genannt. Je nachdem, was der Zweck des Servers ist, bekommt er üblicherweise auch eine sprechende Bezeichnung. Ein „Web-Server“ liefert z.B. auf Anfrage die Inhalte einer Webseite. Ein „E-Mail-Server“ ermöglicht das Speichern, Versenden und Empfangen von E-Mails. Ein „File-Server“ (von engl. „file“ = Datei) bietet einen Platz zum Ablegen von Dateien. Und mittlerweile gibt es natürlich viele Spezialanwendungen vom Wetter-Server, den man nach einer Wetterprognose fragen kann, bis zum Multimedia-Server zum Abruf von Videos, Musik und mehr. Das Internet besteht also aus jeder Menge solcher Server, die rund um die Uhr ihre Dienste zur Verfügung stellen.

Selbst einen Server aufzubauen und an das Internet anzuschließen ist nicht besonders schwer. Das kann prinzipiell jeder zuhause tun. Deshalb ist das Internet so rasant gewachsen. Nicht so einfach ist aber, den Server pausenlos am Laufen zu halten. Wer zuhause einen Computer hat, schaltet ihn normalerweise nur an, wenn er gerade benötigt wird. Ein Server dagegen muss ständig angeschaltet bleiben. Wird er heruntergefahren, ist er für niemanden mehr erreichbar. Statt den gewünschten Antworten auf die Anfragen würden sie eine Fehlermeldung zurückerhalten.

Wer zwei Wochen in Urlaub fährt, sollte schon allein aus Brandschutzgründen alle Elektrogeräte zuhause ausschalten. Aber auch wenn man immer zuhause bleibt, wird es schwierig, den Computer ständig angeschaltet zu lassen. Schon allein um die Programme des Computers auf den aktuellen Stand zu bringen, muss man ihn regelmäßig neustarten. Es könnte aber auch ein Gewitter zu einem Stromausfall führen. Oder ein defektes Stromkabel muss ausgetauscht werden. Vielleicht wird auch nur versehentlich der Stecker aus der Steckdose gezogen. Oder … kurzum: Es gibt unglaublich viele Gründe, warum ein Computer zuhause nicht angeschaltet sein könnte.

Rechenzentren – das perfekte Zuhause für Server

Ein Rechenzentrum bietet daher einen Platz für Computer mit optimalen Bedingungen um sie rund um die Uhr laufen zu lassen. Wer einen Server besitzt kann sich dort ein Plätzchen mieten und erhält vom Rechenzentrumsbetreiber eine Garantie, zum Beispiel „wir garantieren, dass dein Server 99,9% der Zeit läuft“. Niemand wird jemals (seriös) eine 100%-Garantie aussprechen. Trotz aller Anstrengungen, das zu verhindern, bleibt immer ein Restrisiko.

Je kritischer ein Ausfall ist, desto mehr „Neunen“ möchte man hinter dem Komma sehen, um möglichst nahe an 100% zu kommen. Es klingt vielleicht erstmal pingelig ob nun 99,9% oder 99,99% garantiert werden. Doch mit nur einer Neun hinter dem Komma ist ein Ausfall von 8 Stunden im Jahr möglich, bei zwei Neunen schon nur noch knapp weniger als eine Stunde. Bei drei Neunen hinter dem Komma darf der Ausfall nur noch 5 Minuten im Jahr betragen. Jede Neun erhöht also deutlich die garantierte Ausfallsicherheit, allerdings auch erheblich den Preis.

Damit das überhaupt möglich ist, muss im Rechenzentrum einiges geleistet werden. Zunächst einmal ganz Grundlegendes: Es muss sichergestellt werden, dass niemand den Computer anfasst, der dort nichts verloren hat. Ein Rechenzentrumsgebäude hat entsprechende Schutzmaßnahmen (Hohe Mauern, Stacheldraht, Videoüberwachung, Zutrittskontrolle usw.), so dass nur berechtigte Personen bis zum Serverraum kommen. Das sind in der Regel die für die Wartung und den Betrieb zuständigen Spezialisten.

Was passiert, wenn … ?

Darüber hinaus werden nun eine ganze Menge „was passiert, wenn“-Fragen gestellt: „Was passiert, wenn der Strom ausfällt?“ ist zum Beispiel eine naheliegende Frage. Ein Rechenzentrum ist darauf vorbereitet, indem es eigene, meist dieselbetriebene Notstromgeneratoren bereithält. Man spricht hier von „unterbrechungsfreier Stromversorgung“, kurz USV. Fällt die normale Stromversorgung aus, kann das Rechenzentrum somit eine Weile eigenen Strom produzieren. Das kennt man vielleicht auch von anderen Einrichtungen wie Krankenhäusern.

Ein etwas spezielleres Thema, dass alle Rechenzentren beschäftigt, ist dagegen die Klimatisierung. Computer im Dauerbetrieb erzeugen Wärme. Und viele Computer erzeugen sehr viel Wärme. Eine zu hohe Temperatur kann dazu führen, dass der Computer ausfällt. „Was passiert, wenn es zu warm wird?“ lautet also die nächste Frage. Eine Klimaanlage zur Kühlung ist daher in jedem Rechenzentrum vorhanden. „Was passiert, wenn die Klimaanlage ausfällt?“ – auch hierfür müssen Notfallpläne vorhanden sein. Eine zweite Klimaanlage, die übernehmen kann, ein Reparaturteam, dass innerhalb kurzer Zeit vor Ort sein kann, und so weiter. Übrigens: Der Energieaufwand zum Herunterkühlen der Computer ist dabei enorm, weswegen das Internet auch immer wieder zu den großen Klimasündern gezählt wird. Moderne Rechenzentren versuchen mittlerweile daher durch geschickte Bauweise eine Kühlung an der freien Luft zu erreichen. Und immer häufiger wird versucht, die erzeugte Wärme dorthin zu führen, wo sie nützlich sein kann, z.B. um die Heizkosten in den umliegenden Gebäuden zu senken.

Die „Was passiert, wenn es defekt ist“-Frage muss aber nicht für Strom- und Klimaanlagen, sondern generell bei jeder einzelnen Komponente gestellt werden, die notwendig ist, damit der Computer läuft. Das führt dazu, dass jede dieser Komponenten, also jedes Kabel, jede Steckverbindung, etc. einen einen „Zwilling“ erhält, der im Zweifel nahtlos übernehmen kann. Denn mit der Zeit veralten Komponenten und früher oder später muss alles einmal ausgetauscht werden. Man muss immer darauf vorbereitet sein.

Zwillings-Server

Wenn alle Komponenten einen Zwilling benötigen, dann natürlich auch der Server selbst. Jeder, der zuhause einen Computer, Smartphone oder ähnliches hat kennt das: Damit ein Software-Update gemacht werden kann, muss neu gestartet werden. Ohne Zwilling wäre so ein Neustart ein Ausfall von mehreren Minuten. Manchmal geht bei solchen Updates ja auch etwas schief und hinterher funktioniert der Computer nicht mehr. Dann ist es um so besser, wenn man noch den Zwillings-Server hat, der weiterlaufen kann.

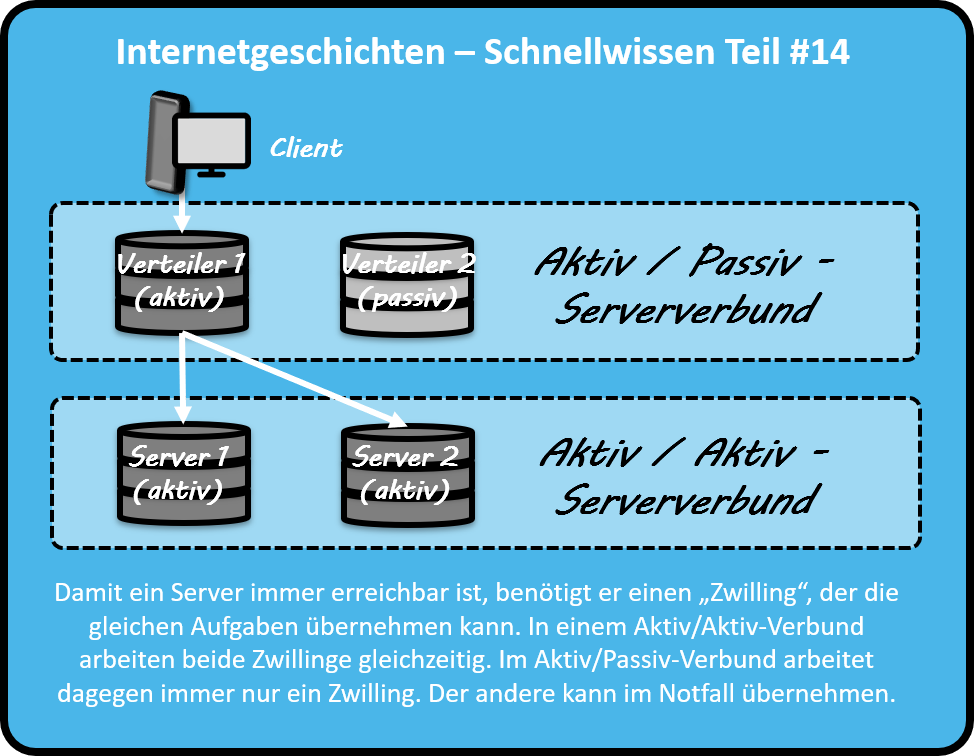

Man unterscheidet zwischen zwei Arten von Zwillingen: Im sogenannten Aktiv-Aktiv-Betrieb sind beide Computer gleichzeitig in Betrieb und teilen sich die Anfragen gleichmäßig auf. Für ein Update wird dann zunächst der eine, anschließend der andere Computer außer Betrieb genommen, so dass immer einer von beiden weiterläuft. Das Ganze hat aber einen Haken: Man benötigt vor den Zwillingen noch einen zusätzlichen Computer, der die Anfragen entgegen nimmt und gleichmäßig auf die beiden Zwillinge verteilt. Tja, und der benötigt dann natürlich auch einen Zwilling. Dafür gibt es den Aktiv-Passiv-Betrieb. Hier arbeitet immer nur einer der beiden Zwillinge. Der passive Zwilling wird nur aktiv, wenn der andere Zwilling ausfällt. Der sogenannte „Failover“ (von englisch „fail“ = Versagen und „switch over“ = „umschalten“) , also der Wechsel von passiv auf aktiv, muss dann sehr schnell und automatisch funktionieren, damit der Ausfall möglichst kurz gehalten wird.

Wir sehen also: Wenn wir umgangssprachlich von „einem Server“ sprechen, dann ist das nur die Außenansicht. Von außen sehen unsere Smartphones, Notebooks, Heim-PCs usw. nur einen Computer mit einer IP-Adresse, dem man Anfragen senden kann. In der Innenansicht sind es dagegen eine ganze Reihe an Computern in einem komlexen Zusammenspiel.

Der K-Fall

Die bislang genannten Punkte waren mehr oder weniger der Alltag im Rechenzentrumsbetrieb. Doch die „Was passiert, wenn“-Fragen gehen einen Schritt weiter. Sie behandeln auch den sogenannten „Katastrophen-Fall“ oder kurz „K-Fall“, bei dem auf einen Schlag ein Teil oder das gesamte Rechenzentrumsgebäude zerstört oder zumindest unbenutzbar wird. Das kann durch unterschiedliche Dinge geschehen. Naturkatastrophen wie Erdbeben oder Hochwasser sind eine Möglichkeit, aber leider auch von Menschen verursachte Terroranschläge oder sonstige kriegerische Akte. In den Jahren nach den Anschlägen vom 11. September 2001 musste man beispielsweise die vorher undenkbare Frage stellen, „Was passiert, wenn ein Flugzeug in das Rechenzentrum stürzt“. Wenn es darum geht, Dinge zu zerstören, können Menschen sehr erfinderisch sein. Aber auch ohne direkte Beschädigung kann der K-Fall eintreten. Ein verunglückter Gefahrguttransport „vor der Haustür“ des Rechenzentrums kann dafür sorgen, dass niemand mehr in das Gebäude kommt. Und ohne das Betriebspersonal vor Ort dauert es nicht lange, bis die ersten Probleme auftreten.

Wer glaubte, dass der K-Fall etwas ist, das im friedlichen, von fatalen Naturkatastrophen meist verschonten Europa zu vernachlässigen ist, dürfte spätestens im März 2021 wachgerüttelt worden sein. In Straßburg an der deutsch-französischen Grenze brannte eines der größten Rechenzentren Europas komplett nieder, vermutlich nachdem das Feuer in der internen Stromversorgungsanlage ausgebrochen war. Ein fünfstöckiges Gebäude mit über 12.000 Servern darin wurde innerhalb weniger Stunden vollkommen vernichtet. Ein benachbartes Rechenzentrumsgebäude wurde zudem teilweise zerstört, zwei weitere wurden sicherheitshalber zunächst außer Betrieb genommen. Mehrere Millionen Webseiten waren schlagartig nicht mehr verfügbar und die Unternehmen, welche die Server benutzt hatten, erlitten einen enormen Datenverlust. Solche Ereignisse machen immer wieder deutlich: „Internet“, „Cloud“, „CyberSpace“ – das klingt stets nach virtuellen Welten, am Ende basiert aber alles auf echten, anfassbaren Elektrogeräten, die irgendwo in ganz realen Gebäuden stehen und kaputtgehen können.

Was hilft denn aber nun beim Eintritt eines K-Falls? Die Antwort ist eigentlich relativ simpel, wir haben sie oben sogar schon gegeben: Jede Komponente benötigt einen Zwilling, der im Notfall übernehmen kann. Diesen Grundsatz muss man nun eben auch auf das gesamte Rechenzentrumsgebäude anwenden. Man benötigt dafür ein zweites Rechenzentrum, das natürlich nicht zu nahe am ersten stehen sollte, um nicht von der gleichen Katastrophe betroffen zu sein. Die beiden Standorte werden durch eine schnelle Leitung miteinander verbunden. Alle Daten aus dem ersten Rechenzentrum werden regelmäßig an das zweite Rechenzentrum kopiert. Fällt der erste Standort aus, kann auf den zweiten geschwenkt werden. Je schneller und häufiger man die Kopien erzeugt, desto weniger Daten gehen im K-Fall verloren. Desto teurer wird die Lösung allerdings auch. Hier läuft es häufig auf eine Gegenüberstellung von Kosten und Nutzen hinaus. Wenn eine Katastrophe geschieht, ist es aber häufig wichtiger, dass man das Tagesgeschäft zügig fortsetzen kann, als jedes Daten-Bit zu retten.

Neue Bedrohungen

Damit sollte dann aber auch wirklich jedes Szenario abgedeckt sein, oder? Leider nein. Denn es gibt mittlerweile eine neue Art Katastrophen-Fall, gegen den auch zwei Rechenzentren an verschiedenen Standorten keine Sicherheit bieten. Die Rede ist nicht von einem Meteoriteneinschlag, der den ganzen Planeten erfasst (da hoffen wir auf eine Bruce-Willis-Lösung), sondern schadhafte Computerprogramme wie Viren und vor allem die sogenannten „Verschlüsselungstrojaner“. Diese Verschlüsselungstrojaner werden von Kriminellen über Sicherheitslücken auf einem Computer eingeschleust. Daraufhin verschlüsselt der Trojaner sämtliche Daten auf dem Computer, so dass sie nicht mehr genutzt werden können, außer man kennt ein geheimes Passwort. Dieses muss man sich dann durch Zahlung eines Lösegelds erkaufen. Man spricht daher auch von „Ransomware“ (zusammengesetzt von englisch „ransom“ = „Lösegeld“ und „software“ = „Computerprogramm“).

Ein befallener Computer ist damit im Prinzip verloren, obwohl es am Rechenzentrum keine Schäden gab. Das besonders Problematische ist aber, dass die regelmäßigen Kopien in ein zweites Rechenzentrum die Schadsoftware einfach mitkopieren würden. Damit wäre innerhalb kurzer Zeit auch der Computer am zweiten Standort befallen und genauso verloren. Die Bedrohung durch Ransomware ist aus diesem Blickwinkel größer als alle Naturkatastrophen. Hier herrscht regelrecht Krieg zwischen Angreifern, die Sicherheitslücken ausnutzen und Verteidigern, die das verhindern. Bei veralteten Systemen stehen die Verteidiger in der Regel auf verlorenem Posten. Das systematische, schnelle Finden und Schließen von Sicherheitslücken gehört zu den größten und wichtigsten Aufgaben beim Schutz unserer auf Computer basierenden Infrastrukturen.

Das Internet schläft nie

Was können wir also festhalten, warum Wikipedia und Co. nahezu immer verfügbar sind? Die Antwort ist, dass dahinter harte Arbeit steckt. Das Internet schläft nie, weil rund um die Uhr Menschen im IT-Betrieb arbeiten, meist in Schichten organisiert. Dennoch haben IT-Experten häufig das Problem, anderen zu erklären, was ihre tägliche Arbeit ist. Vielleicht denkt Ihr beim nächsten Einkauf im Internet, der nächsten Suchanfrage, der nächsten Online-Überweisung, der nächsten E-Mail oder Messenger-Nachricht ja ein wenig daran, dass das alles nur möglich ist, weil im Hintergrund Leute ihren Job gut machen. Und noch besser wäre es, wenn das unseren Nachwuchs inspirieren würde, ebenfalls eine IT-Karriere einzuschlagen. Denn während sich immer mehr Menschen an das nie schlafende Internet gewöhnen, gibt es noch immer viel zu wenige, die sich in Zukunft darum kümmern, dass das auch so bleibt.

Um keinen Beitrag zu verpassen, kann man die Internetgeschichten mittlerweile auch bei Facebook abonnieren. Und wenn Ihr den Blog unterstützen wollt, gebt ihm dort doch bitte ein „Gefällt mir“.

![]()